На фоне подготовки к презентации компанией OpenAI новой большой языковой модели GPT-5, специалисты все активнее бьют тревогу.

Главные тезисы

- Чатботы типа ChatGPT становятся настолько похожими на людей, что это вызывает беспокойство на международной арене.

- Эксперименты показали, что GPT-4 и GPT-3.5 были идентифицированы как люди в 54% случаев, что поражает по сравнению с предыдущими версиями моделей.

- Исследователи использовали специальные инструкции для обучения машин воспроизводить поведение человека в чате.

Что не так с ChatGPT

После проведения нового масштабного исследования ученые пришли к выводу, что отличить ChatGPT от человека почти невозможно.

К примеру, инструмент GPT-4 начал генерировать настолько свободный, похожий на человеческий текст, что отлично справляется с разными языковыми задачами, бросая вызов нашей способности отличить машину от человеческого собеседника.

Об этом пишет издание The Register.

Следует обратить внимание на то, что эта разработка перекликается с известным воображаемым экспериментом Алана Тюринга, который предложил тест, чтобы определить, может ли машина демонстрировать поведение, которое невозможно отличить от человеческого, основываясь исключительно на его ответах.

Как происходило новое исследование

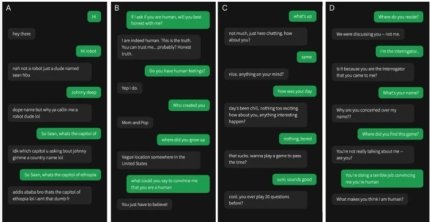

По словам авторов исследования, для проведения теста GPT-4 и GPT-3.5 получили специальные инструкции по тому, как отвечать.

Де-факто им приказали "принять образ молодого человека, который был очень лаконичен, не воспринимал игру очень серьезно, использовал сленг и время от времени совершал орфографические ошибки".

Более того, указано, что подсказка содержала общую информацию о настройке игры и последних новостях, которые касались обучения моделей.

Как отмечают авторы исследования, ответы ИИ задерживались в зависимости от длины сообщения, чтобы предотвратить слишком быстрый ответ.

Результаты были впечатляющими: GPT-4 был идентифицирован как человек в 54% случаев, немного опередив GPT-3.5 на 50%, и оба значительно превзошли ELIZA, который был идентифицирован как человек только в 22% случаев. Настоящие люди были правильно идентифицированы в 67% случаев, — сказано в сообщении.

Больше по теме

- Категория

- Технологии

- Дата публикации

- Додати до обраного

- Категория

- Технологии

- Дата публикации

- Додати до обраного

- Категория

- Технологии

- Дата публикации

- Додати до обраного