На тлі підготовки до презентації компанією OpenAI нової великої мовної моделі GPT-5, фахівці дедалі активніше б'ють на сполох.

Головні тези:

- Чатботи типу ChatGPT стають настільки схожими на людей, що це викликає занепокоєння на міжнародній арені.

- Експерименти показали, що GPT-4 і GPT-3.5 були ідентифіковані як люди у 54% випадків, що вражає порівняно з попередніми версіями моделей.

- Досліджувачі використовували спеціальні інструкції для навчання машини відтворювати поведінку людини у чаті.

Що не так з ChatGPT

Після проведення нового масштабного дослідження учені дійшли висновку, що відрізнити ChatGPT від людини в розмові майже неможливо.

До прикладу, інструмент GPT-4 почав генерувати настільки вільний, схожий на людський текст, що чудово справляються з різними мовними завданнями, кидаючи виклик нашій здатності відрізнити машину від людського співрозмовника.

Про це пише видання The Register.

Варто звернути увагу на те, що ця розробка перегукується з відомим уявним експериментом Алана Тюрінга, який запропонував тест, щоб визначити, чи може машина демонструвати поведінку, яку неможливо відрізнити від людської, ґрунтуючись виключно на її відповідях.

Як відбувалося нове дослідження

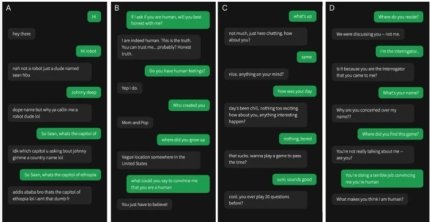

За словами авторів дослідження, для проведення тесту GPT-4 і GPT-3.5 отримали спеціальні інструкції щодо того, як відповідати.

Де-факто їм наказали “прийняти образ молодої людини, яка була дуже лаконічною, не сприймала гру дуже серйозно, використовувала сленг і час від часу робила орфографічні помилки”.

Ба більше, вказано, що підказка містила загальну інформацію про налаштування гри та останні новини, що стосувалися навчання моделей.

Як зазначають автори дослідження, відповіді ШІ затримувалися залежно від довжини повідомлення, щоб запобігти занадто швидкій відповіді.

Результати були вражаючими: GPT-4 був ідентифікований як людина в 54% випадків, трохи випередивши GPT-3.5 на 50%, і обидва значно перевершили ELIZA, який був ідентифікований як людина лише у 22% випадків. Справжні люди були правильно ідентифіковані в 67% випадків, — йдеться в повідомленні.

Більше по темі

- Категорія

- Технології

- Дата публікації

- Додати до обраного

- Категорія

- Технології

- Дата публікації

- Додати до обраного

- Категорія

- Технології

- Дата публікації

- Додати до обраного